බ්රිතාන්යයේ AI නීති දැඩි වෙයි: Deepfakes පාලනයට හදිසි නියෝගයක්

එංගලන්තයේ නව නීති මගින් AI මෙවලම් නිර්මාණකරුවන් සෘජුවම වගකීමට බැඳේ. Deepfakes පාලනයට ගත් මෙම හදිසි පියවර ඔබේ Tech Startup එකට හෝ ඩිජිටල් ජීවිතයට බලපාන ආකාරය කියවන්න.

බ්රිතාන්යයේ AI නීති දැඩි වෙයි: Deepfakes පාලනයට හදිසි නියෝගයක්

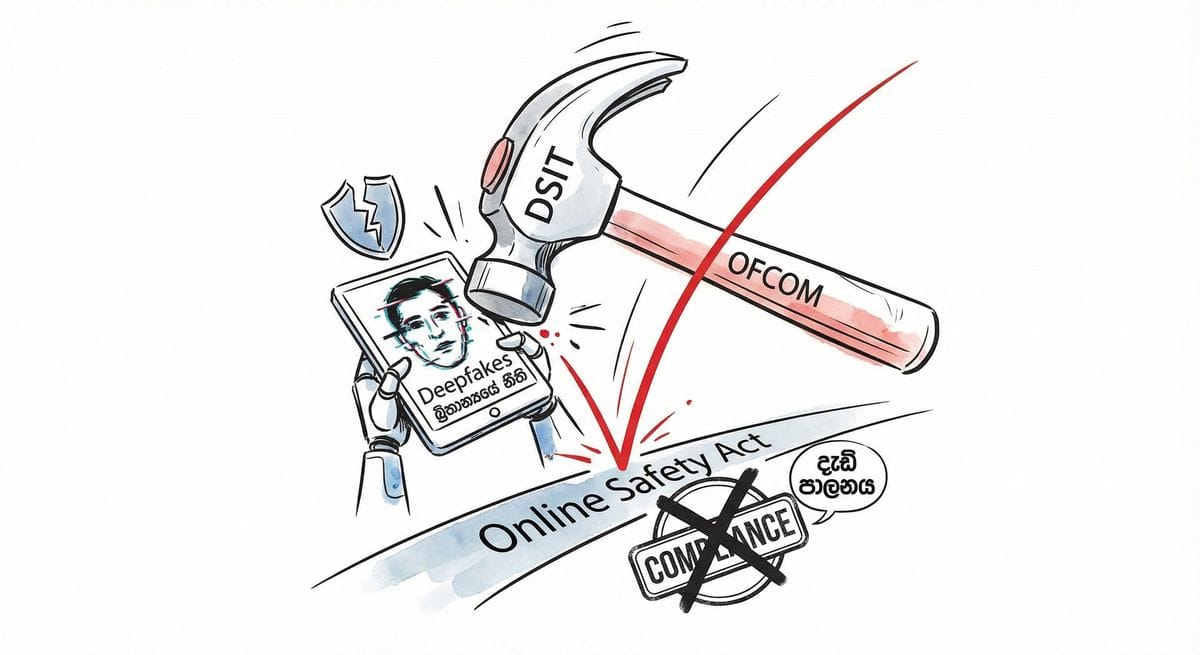

එක්සත් රාජධානියේ ඩිජිටල් ක්ෂේත්රය අද උදෑසන තීරණාත්මක වෙනසකට භාජනය විය. විද්යා, නවෝත්පාදන සහ තාක්ෂණ දෙපාර්තමේන්තුව (DSIT) විසින් Ofcom වෙත හදිසි අමාත්ය විධානයක් (Ministerial Directive) නිකුත් කර තිබේ. මෙහි අරමුණ වන්නේ Online Safety Act 2023 (OSA) යටතේ AI මගින් නිර්මාණය කරන Deepfakes සහ රූප නිර්මාණ මෙවලම් (Image generation tools) සඳහා නීතිය දැඩිව ක්රියාත්මක කිරීමයි.

එක්සත් රාජධානියේ වෙසෙන ශ්රී ලාංකික තාක්ෂණික ප්රජාවට—විශේෂයෙන් Tech Founders ලා, මෘදුකාංග ඉංජිනේරුවන් සහ ඩිජිටල් වෘත්තිකයන්ට—මෙය හුදෙක් ප්රතිපත්තිමය යාවත්කාලීන කිරීමක් පමණක් නොවේ; මෙය ඔබගේ ව්යාපාරික මෙහෙයුම්වලට බලපාන බරපතල සංඥාවකි. බ්රිතාන්යයේ AI සංවර්ධනයේ මෙතෙක් පැවති "Move fast and break things" යුගය නිල වශයෙන් අවසන් වී ඇත.

මූලික වෙනස: වගකීම (Liability) සංවර්ධකයා වෙතට

Online Safety Act එක 2023 ඔක්තෝම්බර් මාසයේදී සම්මත වූ දා සිට නියාමකයින් විසින් විවාද කළ ප්රධාන නීතිමය හිඩැසක් (Loophole) මෙම විධානය මගින් වසා දමයි. මීට පෙර අවධානය යොමු වූයේ නීතිවිරෝධී අන්තර්ගතයන් බෙදා හරින පුද්ගලයින් වෙතය. නමුත් මෙම නව නීතිය මගින් ඉලක්ක කරන්නේ එම අන්තර්ගතයන් නිර්මාණය කරන මෙවලම් (Tools) ය.

නියාමන පසුබිම: පෙර සහ පසු

| විශේෂාංගය | පෙර තත්වය (2026 ට පෙර) | නව තත්වය (වර්තමාන නීතිය) |

|---|---|---|

| මූලික වගකීම | නීතිවිරෝධී දේ හුවමාරු කරන පරිශීලකයින් (Users) සහ පැමිණිලි ලැබුණු විට ඒවා ඉවත් නොකරන වේදිකා වෙත යොමු වී තිබුණි. | මෙය AI මෙවලම් නිර්මාණය කරන සංවර්ධකයින් (Developers) වෙත ව්යාප්ත වේ. ඔබේ මෙවලම හරහා නීතිවිරෝධී දේ පහසුවෙන් සෑදිය හැකි නම්, ඔබ වගකිව යුතුය. |

| අනුකූලතා ආකෘතිය | "Notice and Takedown": හානියක් වාර්තා වූ පසු ප්රතිචාර දැක්වීම. | "Safety by Design": නිෂ්පාදනය එළිදැක්වීමට පෙර අවදානම් ඇගයීම් සිදු කිරීම අනිවාර්ය වේ. |

| Deepfakes | අවසරයකින් තොරව රූප හුවමාරු කිරීම නීතිවිරෝධී විය. | එවැනි රූප නිර්මාණය කිරීම වැළැක්වීම සඳහා මෙවලම් තුළ "ඉතා ප්රබල" ආරක්ෂක විධිවිධාන තිබිය යුතුය. |

| බලතල | ක්රියාත්මක වීම ප්රමාද විය; සහන කාලයන් ලබා දී තිබුණි. | හදිසි ප්රමුඛතාවය: අනුකූල නොවන AI ආයතනවලට එරෙහිව වහාම දඩ නියම කිරීමට Ofcom වෙත බලය පවරා ඇත. |

උපායමාර්ගික විශ්ලේෂණය: එක්සත් රාජධානියේ ශ්රී ලාංකිකයින්ට බලපාන ආකාරය

අපගේ ප්රජාවට මෙය අවදානම සහ අවස්ථාව යන දෙකම කැටි වූ තත්වයකි.

1. තාක්ෂණික වෘත්තිකයන්ට ඇති අවදානම එක්සත් රාජධානියේ බොහෝ ශ්රී ලාංකික ඉංජිනේරුවන් සහ ව්යවසායකයින් SaaS සහ AI Startups වල සේවය කරයි. ඔබ Generative AI ඒජන්තවරුන්, Chatbots හෝ රූප නිර්මාණ මෙවලම් ගොඩනගන්නේ නම්, ඔබේ "Minimum Viable Product" (MVP) වෙළඳපොළට ගෙන ඒම සඳහා තිබූ බාධකය දැන් ඉතා ඉහළ ගොස් ඇත.

- කළ යුතු දේ: ඔබ වහාම Systemic Risk Assessment එකක් සිදු කළ යුතුය. දේශපාලනඥයන්ගේ හෝ වෙනත් පුද්ගලයින්ගේ Deepfakes නිර්මාණය කිරීමට ඔබේ මෙවලම "Jailbreak" කළ හැකි නම්, ඔබ නීතියට අනුකූල නොවේ (Non-compliant). "පරිශීලකයින් අපගේ මෙවලම වැරදි ලෙස භාවිතා කළා" යන්න තවදුරටත් වලංගු නීතිමය තර්කයක් නොවේ.

2. ඩිජිටල් අනන්යතාවය සහ මූල්ය වංචා ශ්රී ලංකාවට මුදල් යැවීමේදී (Remittances) සංක්රමණිකයින් මුහුණ දෙන ප්රධාන ගැටලුවක් වන්නේ Deepfakes හරහා සිදුවන වංචාවන් ය. වංචාකරුවන් පවුලේ සාමාජිකයන්ගේ කටහඬ සහ රූපය (Voice clones & Deepfake videos) භාවිතා කර මුදල් ඉල්ලා සිටින අවස්ථා බහුලව වාර්තා වේ.

- වාසිය: මෙම දැඩි නීති මගින් වේදිකාවලට (Platforms) දැඩි අනන්යතා තහවුරු කිරීම් (Identity verification) ක්රියාත්මක කිරීමට බල කෙරේ. මෙය අපගේ ප්රජාව පීඩාවට පත් කරන "Grandparent scams" සහ හදිසි මූල්ය වංචා අවම කිරීමට ඉවහල් විය හැකිය.

විකල්ප දෘෂ්ටිකෝණය: නවෝත්පාදනයට බාධාවක්ද?

සමබර දැක්මක් පවත්වා ගැනීම සඳහා අප ඇසිය යුතු ප්රශ්නයක් තිබේ: ආරක්ෂාව සඳහා ගෙවන මිල කුමක්ද?

- "Startup Chill" අවදානම: Online Safety Act එකට අනුකූල වීම සඳහා යන වියදම (Compliance costs) ඉතා ඉහළ ය. Google හෝ OpenAI වැනි දැවැන්තයින්ට මේ සඳහා කණ්ඩායම් යෙදවිය හැකි වුවත්, කුඩා Startups—බොහෝ විට සංක්රමණික ව්යවසායකයින්—මීට මුහුණ දීමට අපහසු විය හැකිය. වගකීම් මගහැරීම සඳහා කුඩා ක්රීඩකයින් වෙළඳපොළෙන් ඉවත් වුවහොත්, මෙය Big Tech ඒකාධිකාරයක් නිර්මාණය කිරීමට හේතු විය හැක.

- Open Source ගැටළු: Hugging Face වැනි තැන්වල ඇති Open-source මාදිලි සඳහා මෙය අදාළ වන්නේ කෙසේද යන්න පැහැදිලි නැත. සංවර්ධකයෙකු නිකුත් කරන කේතයක් වෙනත් අයෙකු වෙනස් කර නීතිවිරෝධී වැඩකට යොදා ගත්තොත්, මුල් සංවර්ධකයා වගකිව යුතුද? මෙම නීතිමය අවිනිශ්චිතතාවය කේත දායකයින්ට (Code contributors) අවදානමක් ගෙන දෙයි.

අවසාන නිගමනය

මෙය හුදෙක් වේදිකා පාලනයෙන් (Platform governance) ඔබ්බට ගොස් නිෂ්පාදන පාලනය (Product governance) වෙත මාරු වීමකි. ඔබ AI ගොඩනගන්නේ නම්, ඔබේ කේතයේ මුල් පේළියේ සිටම ආරක්ෂාව (Safety) තහවුරු කළ යුතුය. ඔබ AI භාවිතා කරන්නෙකු නම්, දැඩි පරීක්ෂා කිරීම් බලාපොරොත්තු වන්න; නමුත් එය ඔබේ මූල්ය සුරක්ෂිතතාවය සහ ඩිජිටල් පරිසරය වඩාත් ආරක්ෂිත කරනු ඇත.

මූලාශ්රය (Source): https://www.gov.uk/government/news/technology-secretary-statement-on-xais-grok-image-generation-and-editing-tool